Handelt es sich hierbei etwa um eine Technologie, die ähnlich wie Röntgenstrahlen beim menschlichen Körper funktionieren, nur für Geschäftsprozesse? Das wäre eine geniale Idee mit viel Potenzial.

Wissen wir denn, wie unsere Geschäftsprozesse in der Realität ablaufen und wie die Arbeitsabläufe über Menschen, Prozesse und Systeme hinweg zusammenspielen?

Besteht die Möglichkeit, Geschäftsprozesse zu visualisieren und zu verstehen?

Diese und ähnliche Gedanken haben sich Wissenschaftler weltweit gestellt. Eine herausragende Stellung nimmt in diesem Kontext der niederländische Wissenschaftler Prof. Dr. Wil van der Aalst als Vordenker und Pionier ein. Er beschäftigte sich bereits Ende der 1990er Jahre mit diesem Themengebiet. Bis heute sind noch nicht alle Teilbereiche erforscht und es kommen immer wieder neue Aufgabengebiete hinzu.

Mein Interesse für dieses Thema und Recherchen ergaben, dass es bereits dutzende von kommerziellen Anbietern in diesem Marktsektor gibt, die um die Analysen von Geschäftsprozessen der Kunden buhlen. Führende IT- Unternehmen und Investoren haben frühzeitig das Potenzial im Markt erkannt und durch Zukäufe ihr Portfolio erweitert.

Gartner prognostizierte für dieses Marktsegment im Jahr 2021 ein Umsatzvolumen von einer Milliarde Dollar. Eine detaillierte Prozessanalyse auf Basis der Prozessspuren ist nur die halbe Wahrheit, eine Prozessoptimierung aufgrund der Problemidentifikation ist die wahre End-to-End Lösung für den Kunden.

Funktionsweise von Process Mining

In den operativen Systemen der Unternehmen werden immer mehr Daten produziert, was jährlich zu einem exponentiellen Zuwachs führt. Diese Datenströme hinterlassen in den Prozessen digitale Fußspuren. Diese Spuren werden in sogenannte Event-Logs geschrieben. Dabei handelt es sich um Aktivitäten und Ereignisse, die innerhalb eines Prozesses von einem Business Objekt (ID) generiert werden.

ID, Aktivität und Zeitstempel sind die wesentlichen Schlüsselfelder im Event-Log, worauf Process Mining seine Analysen stützt. Zusätzlich können beschreibende Attribute wie Ressourcen, Eingangskanäle oder Belegarten hinzugefügt werden. Sie dienen einer besseren Erklärbarkeit im Ergebnis. Der Prozessablauf der ID wird als Diagramm an chronologisch ablaufenden Events dargestellt.

Entscheidungsträger können mithilfe dieser digitalisierten Prozessvisualisierung fundierte Entscheidungen treffen. Es lassen sich dabei einzelne Prozessschritte, wenn notwendig bis auf Detailebene, nachvollziehen. Schwachstellen und Ausreißer, die den Prozessfluss ineffizient gestalten, werden sichtbar. Diese Prozessineffizienzen bieten Ansatzpunkte für eine effektive Optimierung des Prozessablaufs.

Proof of Concept (PoC) für Process Mining

Bei der Umsetzung eines Prototyps haben wir uns für die Open Source Python Bibliothek „pm4py“ entschieden, die vom Fraunhofer FIT und Studierenden der RWTH Aachen entwickelt wurde. Unser Ziel war es, einen Prozess nur anhand des Event-Logs mittels eines datenzentrierten Analyseverfahrens zu verstehen und visuell darzustellen.

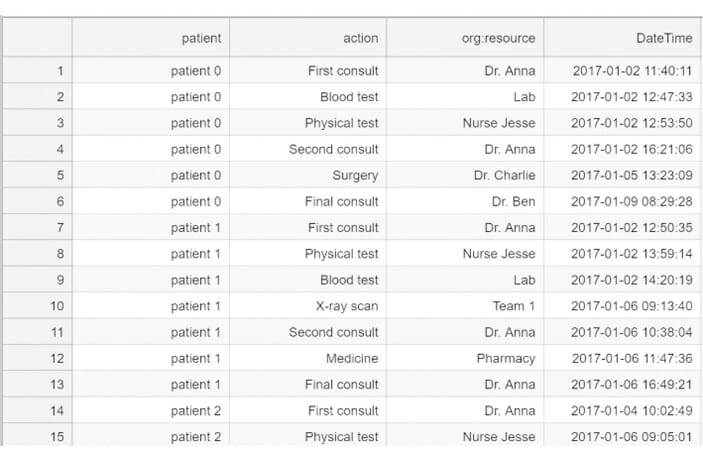

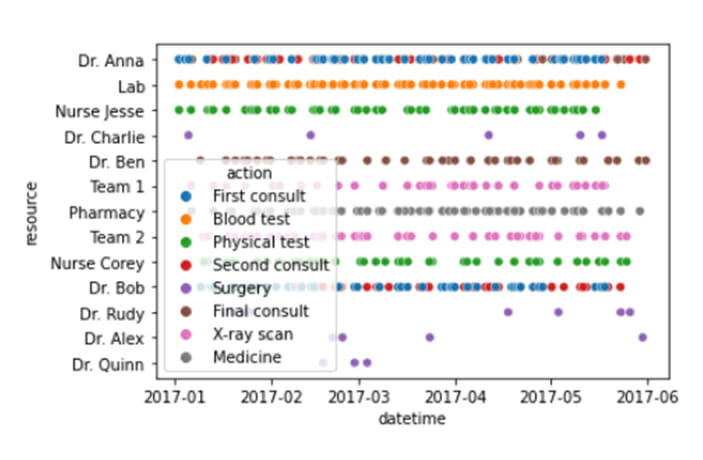

Als Einstieg nutzten wir ein Tutorial für pm4py zur Analyse eines Krankenhausprozesses. Die Logdatei enthielt eine Tabelle mit den Feldern Patienten-ID, Aktion, Ressource und Zeitstempel.

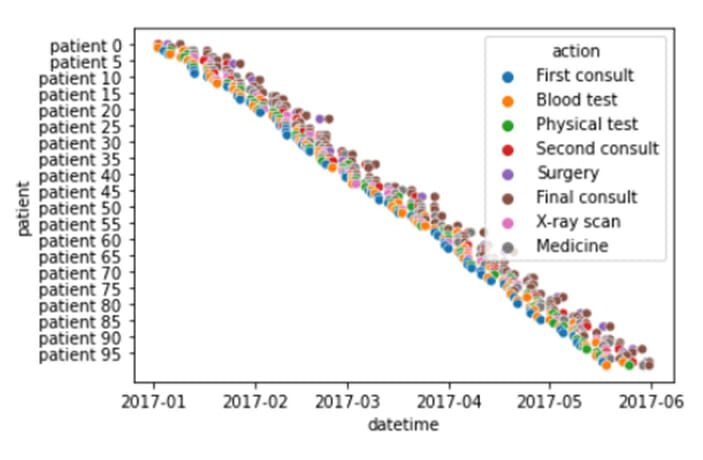

Im ersten Schritt wurden die Eventdaten aufbereitet und statistische Berechnungen auf Patientenebene durchgeführt. Weitere Attributfelder, wie beispielsweise Prozessbeginn und -ende, Anzahl der Aktivitäten und Durchlaufzeit je Patienten, wurden ergänzt. Im Anschluss konnten erste Attribute in Beziehung gestellt und als Grafik in Streudiagrammen angezeigt werden.

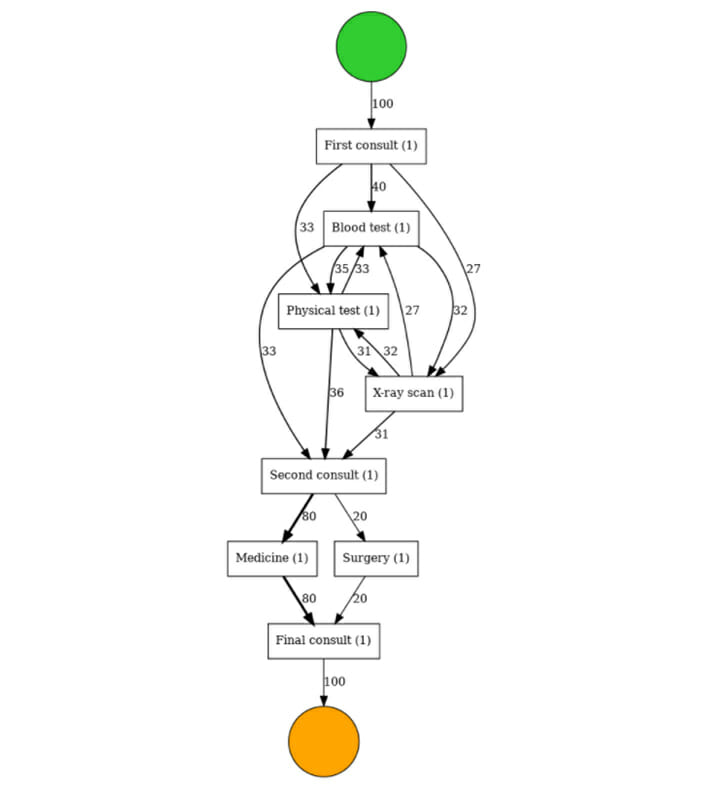

Die Bibliothek pm4py bietet eine Vielzahl an Funktionalitäten rund um das Thema Process Mining. Dazu zählen unterschiedliche Algorithmen für das Process Discovery, wie zum Beispiel der Alpha -, Heuristic – und Inductive Miner. Für eine praxisbezogene Anwendung nutzten wir den Heuristic Miner, der uns eine gute Prozessübersicht lieferte.

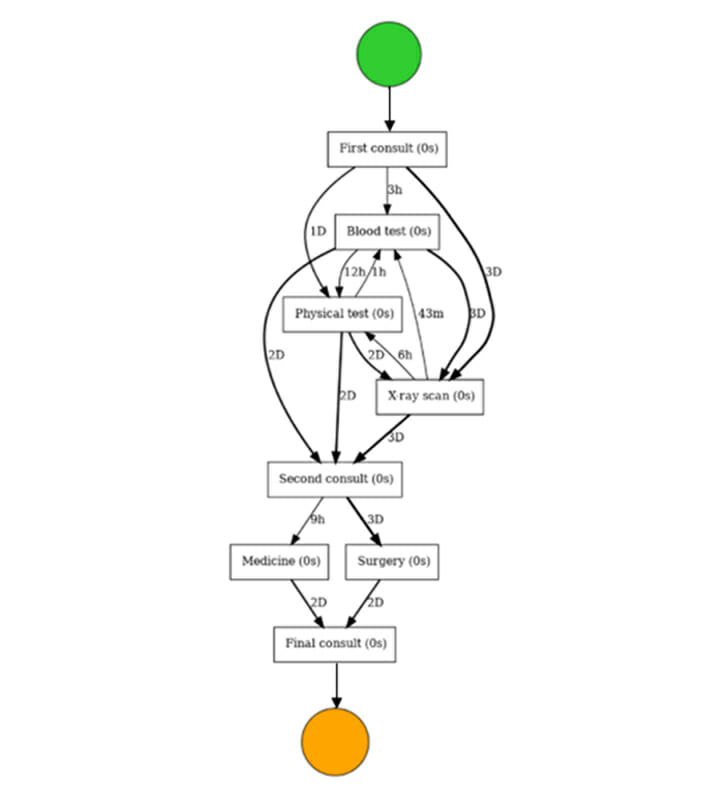

Der Inductive Miner ist der Algorithmus für das eigentliche Process Discovery, der uns den Prozessablauf in einem sogenannten Directly-Follows-Graph (DFG) anzeigt. Es können verschiedene Annotationsvarianten gewählt werden, beispielsweise eine Darstellung anhand der Durchlaufanzahl oder der -zeiten.

Der PoC hat uns gezeigt, dass Prozesse allein anhand des digitalen Fußabdrucks, dem Event-Log, rekonstruiert werden können. Das Tool bietet eine Vielzahl von Möglichkeiten, zum Beispiel eine Konformitätsprüfung, bei der der Ist-Prozess mit dem Soll-Prozessmodell verglichen werden kann. Der Fortschritt dieser Technologie zeigt uns verschiedene Wege, Prozesse zu visualisieren und zu analysieren.

Mit dem PoC konnte bestätigt und unterstrichen werden, dass Prozessanalysen Schwachstellen, Engpässe sowie inakzeptable Prozessabweichungen aufzeigen und Entscheidungsgrundlagen für Optimierungspotenziale liefern. Ein vorausschauendes, permanentes Monitoring konsolidiert die Ergebnisse und bringt Transparenz auf das tatsächliche Unternehmensgeschehen.

So können Unternehmen ihre Potenziale ausschöpfen, Prozesse schlank und effizient gestalten, standardisieren, Kosten senken und sich gut für die digitale Zukunft rüsten. Die Analyse und Automatisierung von Geschäftsprozessen sind wichtige Triebfedern, um agiler auf Kunden und Märkte zu reagieren.

Blick in die Zukunft

Ein Ausblick in die Zukunft zeigt, dass Prozessanalysen nicht mehr nur auf Basis historischer Daten erfolgen, sondern zusätzlich mit Echtzeitdaten der Prozesse angereichert werden. Diese unterschiedlichen Datenarten lassen durch eine geschickte Korrelation einen möglichen Drift der Prozesse erkennen und dienen einer neuen, zukunftsorientierten Unterstützung für Entscheider.

Weiterhin ist es wichtig, die Abhängigkeiten der Prozesse in ihrer Performance zu beobachten. Prozesse im Unternehmen sind filigran und vielschichtig aufgebaut, es bestehen kohärente Beziehungen untereinander. Diese als Gesamtheit zu überblicken und für optimale Transparenz zu sorgen, ist eine große Herausforderung für Lösungsanbieter.